Da sempre acerrima rivale di Nvidia, che continua imperterrita a dimostrare le sue capacità di creare unità grafiche sicuramente appetibili per gli utenti e di conseguenza il mercato, AMD starebbe preparando una controffensiva che vede al centro il nuovo processo produttivo “FinFET”, che consentirà di ottenere GPU costruite con un’architettura a 16 nanometri, proponendo un aumento di prestazioni sostanzialmente mai visto fino ad ora.

Nvidia, che decisamente si rivela una protagonista incontrastata del segmento di unità grafiche consumer a livello mondiale (detenendo l’82% della quota complessiva) potrebbe così trovare pane per i propri denti, grazie alla nuova AMD Greenland.

Questo è il nome in codice della nuova unità grafica che inizialmente era stata concepita come soluzione integrabile sulle APU next-gen (unità di elaborazione hardware ibride, che coniugano la componente CPU ad elementi quali GPU o simili).

Secondo le ultime indiscrezioni, la nuova famiglia di chip Greenland di AMD dovrebbe includere le GPU “embedded”, ovvero integrate, così come le altre soluzioni dedicate alla fascia medio-alta dei computer desktop, ovvero le tanto attese AMD Radeon 400 Series, una famiglia di GPU che vedrà probabilmente la luce entro il 2016 e sarà dedicata ai PC high-end a causa delle sue innovative prestazioni.

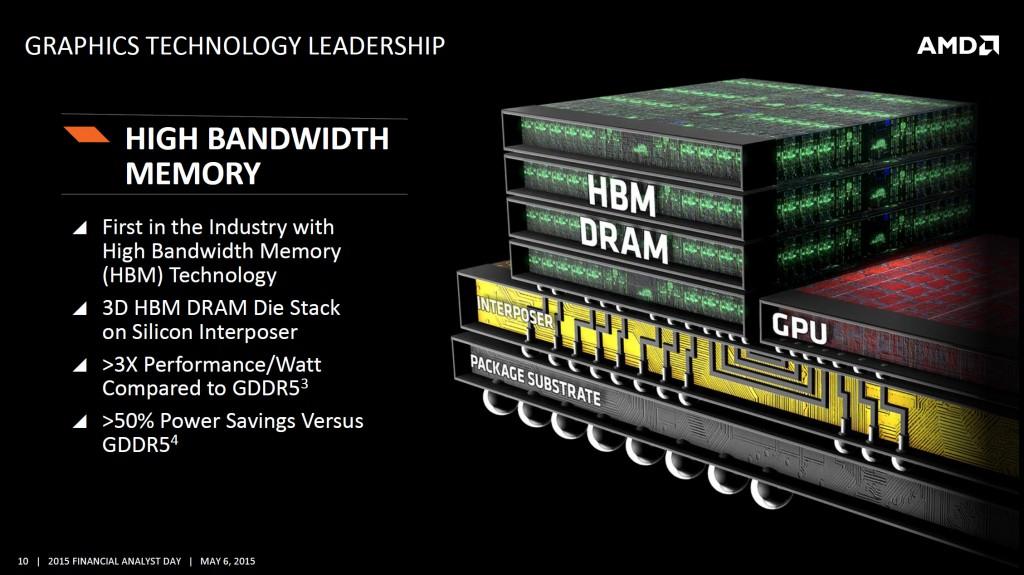

La nuova roadmap di AMD prevederà quindi uno scontro diretto con l’attuale architettura “Pascal” di Nvidia, sul fronte dei 16 nanometri; la nuova GPU Greenland integrerà inoltre 18 miliardi di transistor, che verranno affiancati alle memorie di nuova concezione HBM2 (High Bandwidth Memory 2), studiate per essere utilizzate assieme a dispositivi che consentono l’elaborazione e l’accelerazione grafica ad alti livelli, con un’allocazione di risorse migliore a livello hardware.

Come possiamo vedere, lo scontro tra i due giganti dell’hardware è agli esordi, e potremo scoprirne insieme gli esiti entro qualche mese, una volta annunciata la controffensiva di AMD, a cui, come possiamo aspettarci, seguirà una nuova mossa della sempre pronta Nvidia.

Lascia un commento